坤发子奥菲寺

量子比特报告|微信官方账号QbitAI

通过帅气的手势操控投射在眼前的电子影像,是科幻片中的基本配置。

现在,有人把它从科幻电影带入了现实。动动手指,控制眼前的世界。

热衷于制作智能小工具的油管博主Teemu Laurila用树莓Pi DIY了一副可以识别自定义手势的AR眼镜。

把你要设置的手势输入设备,实现炫酷操作。

我有一个大胆的想法!

让我们开始表演吧!

手指上下按住,即可完成亮度调节指令。(这是你的第一人称视角)

手势识别叠加显示在镜头成像中。

让我们有一个更直的视角,透过眼镜看效果。

AR眼镜科技感十足,让现实世界充满了赛博朋克。

那并不像它那样酷。弹指一挥间就能运行命令,不一定要广为传播?

就这么做吧,首先你需要设计设备会包含哪些部件。

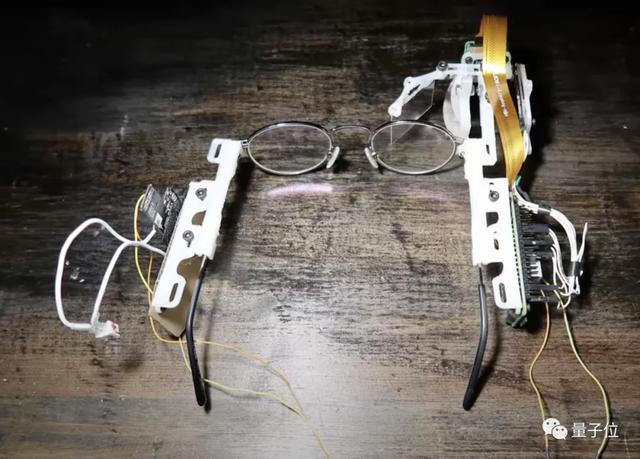

硬件部分除了机身眼镜架,还包括镜头组,0.6 mm PETG投影镜片,配件采用聚乳酸材料3D打印。

毕竟是智能设备的DIY。怎么能不请万能迷你电脑树莓派上台呢?

软件部分,手势识别程序依赖于python开源项目MediaPipe。

除此之外,Teemu Laurila还写了两个程序脚本。

一个是捏手指控制亮度的应用实例,另一个是实时视频中捕捉手势,发送到电脑进行处理,通过智能眼镜叠加。

所有条件都满足,试着组装一下。

经过多次调整,所有部件最终组合成以下装置。

要让程序在设备上可用,首先你需要一个Raspberry Pi作为程序支持。

然后设置内存、驱动、运行环境、多媒体接口、网络等条件,对整个设备进行超频。

硬件环境准备就绪后,调试应用程序。

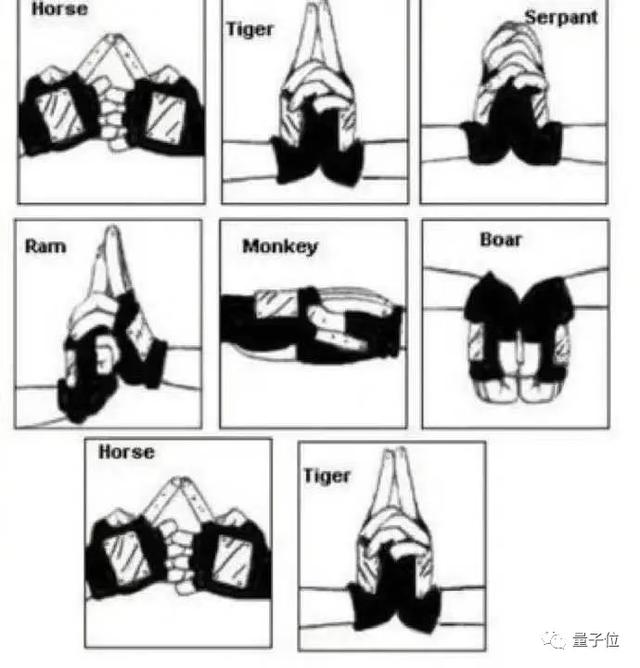

应用功能的核心——手势识别模型由三个框架组成,包括手掌识别模型BlazePalm(用于识别手的整体框架和方向)、地标模型(用于识别三维手部节点)和手势识别模型(用于将识别出的节点归类为一系列手势)。

在识别算法的训练过程中,BlazePalm模型识别手掌的初始位置,优化了移动终端的实时识别。

在BlazePalm识别的手掌内,地标模型识别21个实心节点坐标。

在此基础上,手势识别模型根据关节角度识别每个手指的状态,将状态映射到预定义的手势,预测基本的静态手势。

通过Raspberry Pi Zero W捕捉手势信息,图像传输到电脑,由手势识别AI处理。之后传输到设备,相应的手势命令发出去,同步到投影图像中。

它的前世今生等一下,有一台照相机、一台微型投影仪、一台计算机处理器和一台侧投影显示器。这样的AR眼镜好像在哪里见过。

没错,就连使用的手势识别代码都是谷歌开源的。

虽然没有谷歌智能眼镜类似智能手机的功能,但相比其语音控制和触摸功能,Teemu Laurila的智能眼镜选择使用自定义手势触发命令,更是黑科技。

此外,谷歌眼镜摄像头仅用于拍照和视频,Teemu Laurila的摄像头还承担了接受手势指令和传输指令的功能。同时选择了更大的方形镜头进行投影,方便视野观察。

这款设备是Teemu Laurila完成的第二版智能眼镜,在外观和性能上都进行了优化。

在材质的选择上,使用0.6mm厚的投影镜头,而不是1mm厚;聚乳酸代替丙烯酸;增加了螺栓固定支架,抛弃了胶水。

最重要的优化是相机采用了方形镜头,让画面更清晰。

Teemu Laurila分享了他在GitHub平台上添加的两段代码,供有兴趣的观众复制。

参考链接:

https://www . toms hardware . com/news/raspberry-pi-smart-glasses-recognize-hand-手势

https://www.youtube.com/watch? v = 60 OS 5 iqdbsw

https://www . YouTube . com/watch?v=Gu4oOYo38rQ

GitHub链接:

https://github.com/teneppa/camerastream

https://github.com/teneppa/handtrackingBrightnessControl

—结束—

量子qbitai头条号签约

关注我们,第一时间获悉前沿科技动态。