在做爬虫的过程中,我们经常会遇到这样的情况:一开始爬虫正常运行,正常抓取数据;但一杯茶的功夫就可能出现失误,比如403禁;;这时网页上可能会出现“您的IP访问频率过高”的信息,需要很长时间才能解封,但过一会儿又会出现。

因此,我们使用某种方式来伪装本地IP,使服务器无法识别本地计算机发起的请求,这样我们就可以成功地防止IP被阻止。所以这个时候代理ip就派上用场了。

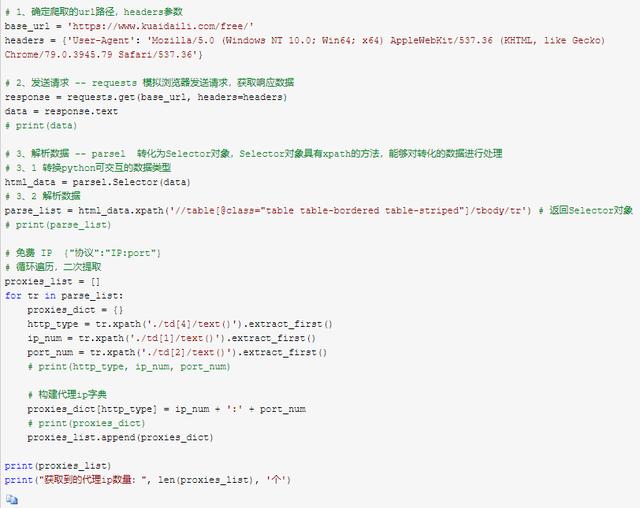

爬虫的一般思路1.确定已爬网url路径和标题参数。

2.Send requests - requests模拟浏览器发送请求并获取响应数据。

3.解析数据——parsel转换成Selector对象,它有xpath方法,可以处理转换后的数据。

4.保存数据

[环境介绍]:python 3.6

路径

要求

parsel(xpath)

代码如下:

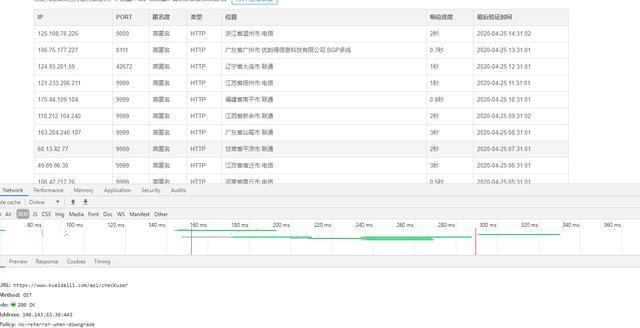

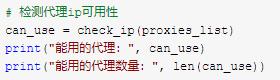

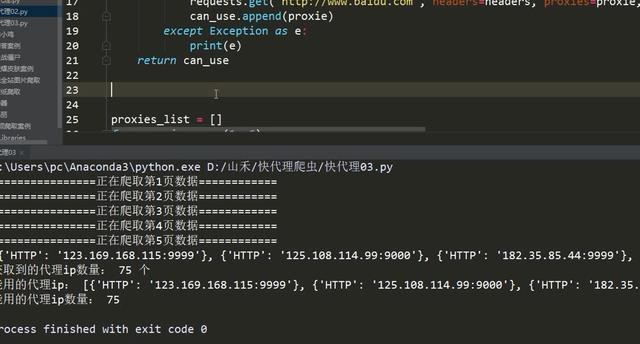

调用ip

效果如下:

多年来,我们开发了老码农的福利礼物:Python爬虫,网站开发,从最基础的基础语法开始,到实际项目【视频+工具+电子书+系统路线图】,都有梳理。有需要的伙伴可以关注一下,私信我。发送“资料”等之后,他们就可以得到地址,3秒钟发给每一个对编程感兴趣的小伙伴。